O lançamento de um novo modelo de inteligência artificial pela OpenAI é tradicionalmente um evento cercado de expectativa e superlativos, prometendo saltos quânticos em capacidade e compreensão. No entanto, a chegada do GPT-5, conforme análise do portal The Register, apresenta uma narrativa um tanto diferente por trás dos holofotes.

Longe de ser apenas uma demonstração de poderio tecnológico, a mais recente criação da empresa parece ser uma jogada estratégica e, talvez, necessária para o controle de custos operacionais. Para uma empresa que carrega a bandeira de ter iniciado a era generativa da IA, a pressão para justificar os bilhões de dólares em financiamento é imensa, e o caminho para o crescimento sustentável pode estar menos na inovação deslumbrante e mais na eficiência financeira.

A equação de negócios da OpenAI é, em teoria, simples: para crescer, a empresa precisa aumentar sua base de usuários, elevar os preços ou reduzir despesas. Com o setor já consolidado em torno de tiers de preço de vinte a duzentos dólares mensais, fica complicado cobrar um valor premium sem oferecer algo verdadeiramente superior. O risco de perder clientes para concorrentes pesados, como a Anthropic e o Google, é real.

Neste contexto, a estratégia de cortar custos sem alienar os usuários torna-se um equilíbrio delicado e importante. A temporada de volta às aulas no hemisfério norte, que tradicionalmente impulsiona assinaturas, ilustra bem o dilema: mais assinantes significam mais receita, mas também implicam em custos de computação ainda mais proibitivos.

A arquitetura da economia

A evidência mais clara desta nova era de contenção de despesas está na própria arquitetura do GPT-5. Diferente de seus predecessores, que eram modelos únicos e monolíticos, o GPT-5 não é um modelo singular. Na realidade, trata-se de um sistema composto por pelo menos dois modelos distintos: um LLM leve e ágil, projetado para responder rapidamente à maioria das solicitações rotineiras, e outro mais pesado e complexo, destinado a lidar com temas que exigem um poder de processamento maior. Um terceiro modelo, totalmente separado, o Image Gen 4o, cuida dos prompts de imagem.

A peça central que orquestra este sistema é um modelo roteador, que funciona como um balanceador de carga inteligente. Sua função é analisar cada prompt enviado pelo usuário e decidir qual dos modelos especializados é mais adequado e economicamente viável para tratá-lo. Em teoria, esta abordagem permite que a grande maioria do tráfego, composto por perguntas simples e cotidianas, seja servida pelo modelo menor e drasticamente menos custoso, reservando o poder de fogo computacional pesado apenas para os casos que realmente o exigem.

Outro movimento econômico perceptível é a decisão da OpenAI de controlar o toggle de “raciocínio” por padrão, ativando-o e desativando-o automaticamente com base na complexidade do prompt. Usuários da versão gratuita do serviço nem sequer têm a opção de controlar esta função manualmente. A lógica por trás disso é direta: quanto menos “raciocínio” os modelos realizam, menos tokens eles geram e, consequentemente, menor é o custo operacional para executar cada consulta.

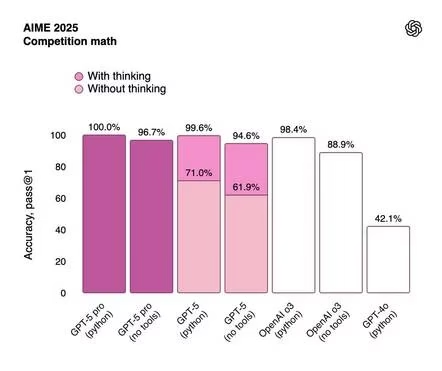

Apesar da arquitetura engenhosa para poupar recursos, uma análise dos benchmarks divulgados pela própria OpenAI revela que esta abordagem não necessariamente resultou em um modelo radicalmente mais inteligente. Os ganhos de desempenho em comparação com os modelos anteriores são considerados modestos pela análise especializada. As áreas que apresentaram as melhorias mais significativas foram na capacidade de chamar ferramentas externas (tool calling) e na redução de alucinações, onde a empresa alega uma diminuição de até oitenta por cento.

O sucesso de todo o sistema, no entanto, depende inteiramente da eficácia do modelo roteador. E, com base no feedback inicial, seu desempenho deixou a desejar. O próprio CEO Sam Altman admitiu que, no dia do lançamento, a funcionalidade de roteamento estava quebrada, fazendo com que o GPT-5 parecesse “muito mais burro” do que realmente era. Este defeito inicial foi o provável culpado por erros embaraçosos, como o modelo afirmar que a palavra “Blueberry” contém apenas uma letra ‘B’. Embora a OpenAI tenha corrigido rapidamente o problema, o incidente expôs a vulnerabilidade de um sistema que depende criticamente de um componente único para tomar decisões basilares.

Aposentadoria forçada

O modelo roteador não foi a única medida de economia implementada. Durante o evento de lançamento, os executivos da OpenAI anunciaram com grande confiança que estariam depreciando todos os modelos anteriores, tornando o GPT-5 a única opção disponível. A justificativa era a crença inabalável na superioridade do novo sistema. A reação da comunidade de usuários, no entanto, foi imediata e negativa.

A pressão foi tanta que Sam Altman retrocedeu, admitindo publicamente que a empresa cometeu um erro. Em suas palavras, ficou claro o forte apego que usuários e empresas desenvolveram por modelos específicos como o GPT-4o, que, apesar de seu desempenho inferior em testes padronizados, havia se tornado parte integrante de fluxos de trabalho e processos estabelecidos.

A remoção abrupta dessas ferramentas, portanto, foi um tiro pela culatra. Apesar do recuo, que restaurou temporariamente o GPT-4o para usuários pagantes, a motivação por trás da depreciação é clara: manter menos modelos em operação significa liberar uma quantidade colossal de recursos computacionais, armazenamento e largura de banda.

Especula-se, com base em modelos de pesos abertos recentes da OpenAI, que o GPT-5 pode utilizar uma forma avançada de quantização, como o MXFP4. Esta tecnologia pode reduzir a necessidade de memória, banda e poder de computação para operar LLMs em até setenta e cinco por cento comparado a formatos anteriores. Migrar todos os usuários para uma plataforma otimizada com essa eficiência representa uma economia de escala monumental, justificando a ânsia da empresa em desativar os sistemas legados.

Memória de curto alcance

Enquanto concorrentes como a Anthropic, com seu Claude, oferecem janelas de contexto de 200 mil tokens, e o Google Gemini chega a suportar impressionantes 1 milhão de tokens, a OpenAI optou por uma postura conservadora. O GPT-5 manteve inalterado o limite de contexto de suas versões anteriores: 8 mil tokens para usuários gratuitos e 128 mil tokens para assinantes Plus e Pro.

Uma janela de contexto, que funciona como a memória de longo prazo do modelo, é fundamental para tarefas como pesquisar e resumir documentos extensos. No entanto, contextos maiores demandam quantidades vastas e caríssimas de memória de GPU. Ao manter os limites enxutos, a OpenAI consegue operar seus modelos com um parque de GPUs significativamente menor, contendo uma das suas maiores despesas operacionais.

Para quem realmente necessita de contextos longos, a OpenAI disponibiliza uma versão da API do GPT-5 que suporta até 400 mil tokens. O acesso a este poder, porém, tem um preço proibitivo: preencher todo o contexto uma única vez custa aproximadamente cinquenta centavos de dólar, um valor que se acumula rapidamente para qualquer uso profissional consistente.

Controlando os danos

Os dias seguintes ao lançamento foram marcados por uma série de manobras de gerenciamento de crise lideradas pelo próprio Sam Altman. Além de trazer de volta o GPT-4o, a empresa concedeu aos usuários pagantes maior controle sobre a velocidade de resposta, com opções como “Auto”, “Rápido” e “Pensando”, e aumentou o limite de mensagens para três mil por semana.

Em comunicados, Altman também esboçou a estratégia de alocação de recursos computacionais para os próximos meses, que, sem surpresa, priorizará clientes pagantes e, em seguida, o uso pesado da API. Somente após satisfazer essas demandas prioritárias é que a empresa considerará melhorar a qualidade do tier gratuito ou expandir a capacidade geral da API.

Para acalmar os ânimos, o CEO prometeu que a capacidade de computação da OpenAI deverá dobrar nos próximos cinco meses, o que, em teoria, aliviaria a pressão sobre os recursos e permitiria uma experiência mais robusta para todos os usuários no futuro.Fique por dentro das principais novidades da semana sobre tecnologia e Linux: assine nossa newsletter!