Nossa ideia começou de forma simples: montar um novo servidor. Não seria o primeiro, já temos outros em funcionamento, mas este teria um foco diferente. A proposta aqui era criar uma máquina capaz de rodar inteligência artificial localmente, sem depender da nuvem, sem enviar dados para terceiros e usando apenas um hardware comum.

Pensando melhor, talvez esse servidor pudesse servir para virtualização, testes diversos e, quem sabe, até rodar um jogo clássico como Crysis. Não como objetivo principal, mas como um experimento curioso. No fim das contas, esse conjunto de possibilidades é um excelente ponto de partida para vários projetos futuros.

O que significa, afinal, rodar IA localmente?

Quando se fala em rodar IA localmente, não se trata de criar algo revolucionário ou competir com gigantes como ChatGPT ou Gemini em escala global. A proposta é bem mais modesta e, justamente por isso, mais acessível.

Rodar IA localmente significa executar modelos de linguagem (LLMs) diretamente no próprio computador, sem depender de servidores externos. É, de certa forma, criar uma versão local desses assistentes, com limitações claras de velocidade, mas com ganhos enormes em privacidade, controle e liberdade.

Nesse projeto específico, a ideia era simples: juntar o hardware disponível no escritório, torcer para que tudo funcionasse e verificar se seria possível rodar alguns modelos populares de forma aceitável em um computador comum de trabalho.

Um projeto baseado no que já existia

A regra é não gastar muito dinheiro. Nada de sair comprando peças novas só para testar uma ideia. O foco é reaproveitar componentes que estão parados.

A base do sistema começou com uma placa-mãe ASUS Prime A320K, acompanhada de 16 GB de memória DDR4, dois pentes de 8 GB de um modelo simples, mas funcional. O processador é um Ryzen 7, embora já não lembrássemos qual modelo. Antes de começar, precisamos descobrir se isso tudo ainda funciona.

Ao remover o cooler, veio o primeiro susto. O processador simplesmente saiu grudado, algo que nunca é um bom sinal. Felizmente, à primeira vista, nada parecia entortado. Mas a quantidade absurda de pasta térmica deixava claro que alguém, no passado, havia sido generoso demais.

Depois da limpeza inicial, veio a identificação do processador: um Ryzen 7 2700X, com oito núcleos e 16 threads. Ainda é um chip bastante competente, especialmente para tarefas paralelas e virtualização.

Mas nem tudo eram boas notícias.

Durante a inspeção mais detalhada, dois pinos do processador chamaram atenção. Um deles estava claramente torto, e outro levemente desalinhado. Não era algo catastrófico, mas suficiente para gerar aquela mistura de tensão, curiosidade e arrependimento que todo entusiasta de hardware conhece bem.

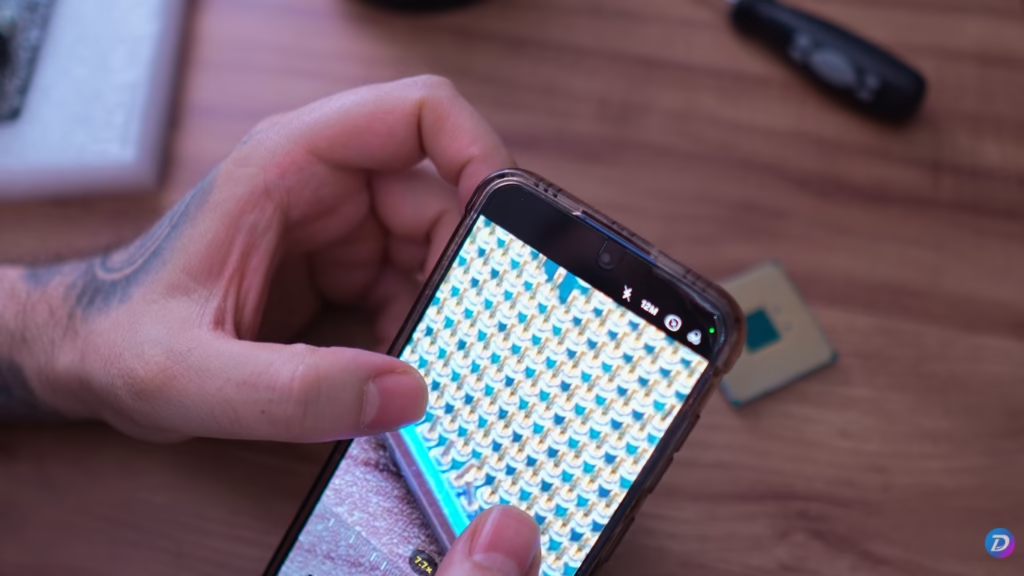

Sem lupa à mão, a solução foi improvisar um microscópio usando o celular. Com muito cuidado, paciência e um pouco de coragem, os pinos foram sendo realinhados lentamente, tentando não piorar a situação.

Depois de algumas tentativas, o processador finalmente voltou a encaixar no socket. A sensação foi de vitória — ainda que provisória. Afinal, encaixar não significa funcionar.

Com o processador de volta ao lugar, a montagem seguiu. Além da memória e da placa-mãe, dois componentes eram fundamentais para o projeto.

O primeiro era o armazenamento. Sem NVMe disponível, a escolha foi um SSD SATA WD Green de 480 GB, mais do que suficiente para testes, modelos de IA e alguns experimentos extras.

O segundo, e talvez mais importante, era a GPU. Aqui entrou uma peça curiosa: a NVIDIA RTX A2000, uma placa voltada para workstations, com 12 GB de memória de vídeo, sem conector de energia adicional e excelente desempenho em tarefas de computação, especialmente IA.

Ela não é pensada para jogos, mas para esse projeto, é praticamente perfeita.

Com tudo conectado — fonte, SSD, GPU, monitor improvisado e periféricos — chegou a hora do teste. O cooler girou, mas o vídeo não apareceu de imediato. Um pequeno estalo gerou apreensão, seguido de uma pausa estratégica para resetar a BIOS.

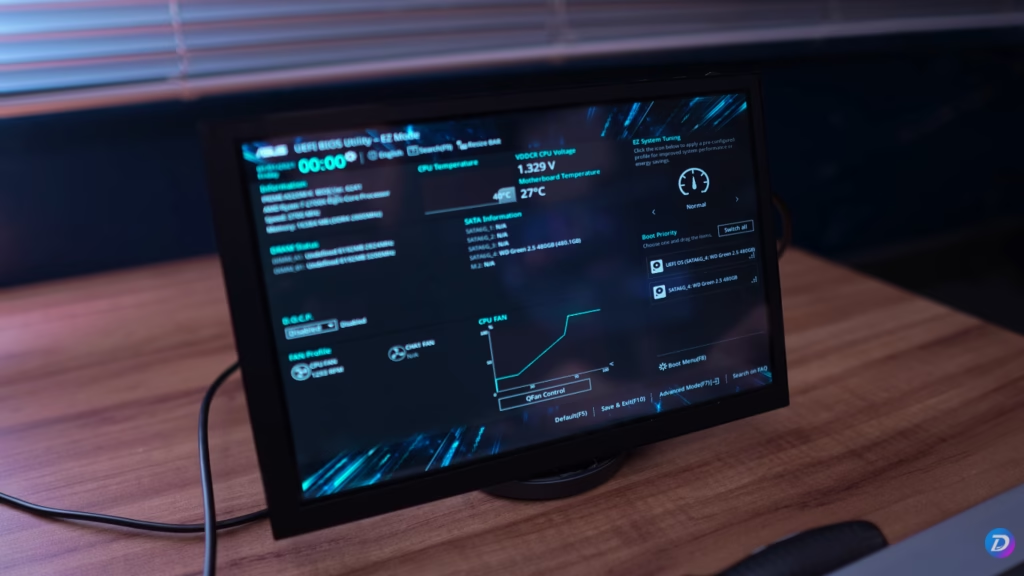

Depois disso, veio o momento esperado: a BIOS apareceu na tela. O sistema reconheceu o SSD, a memória estava funcionando corretamente e o processador havia sobrevivido à cirurgia.

Preparando o sistema para rodar IA

Como sistema operacional, escolhemos o Ubuntu 24.04 LTS, instalado na versão desktop apenas por praticidade. O foco não é o ambiente gráfico em si, mas garantir uma compatibilidade rápida com drivers, especialmente os da NVIDIA.

Durante a instalação, os drivers proprietários foram habilitados, assim como codecs extras. Após o reboot, a confirmação veio: a RTX A2000 estava reconhecida corretamente, com seus 12 GB de VRAM disponíveis.

Agora sim, era hora de testar a ideia principal do projeto.

Rodando modelos de IA com Ollama

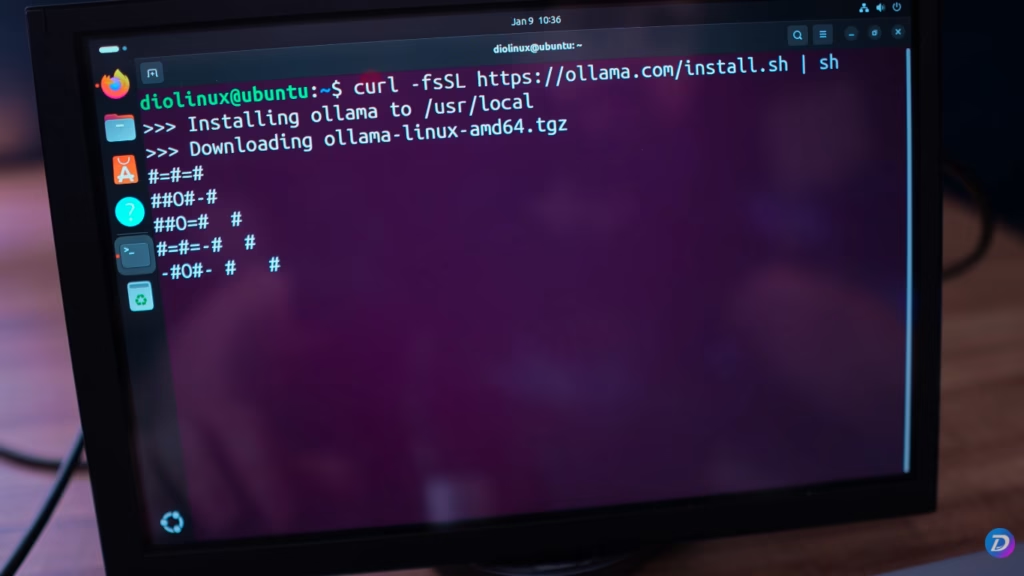

Para executar modelos de linguagem localmente, a ferramenta escolhida foi o Ollama. Ele funciona via linha de comando, é multiplataforma e extremamente simples de usar, o que o torna ideal para servidores e ambientes sem interface gráfica.

Após instalar o Ollama e baixar um modelo leve, como o LLaMA 3.2, o sistema começou a mostrar seu potencial. O modelo foi carregado diretamente na memória da GPU, e as respostas começaram a surgir em poucos segundos.

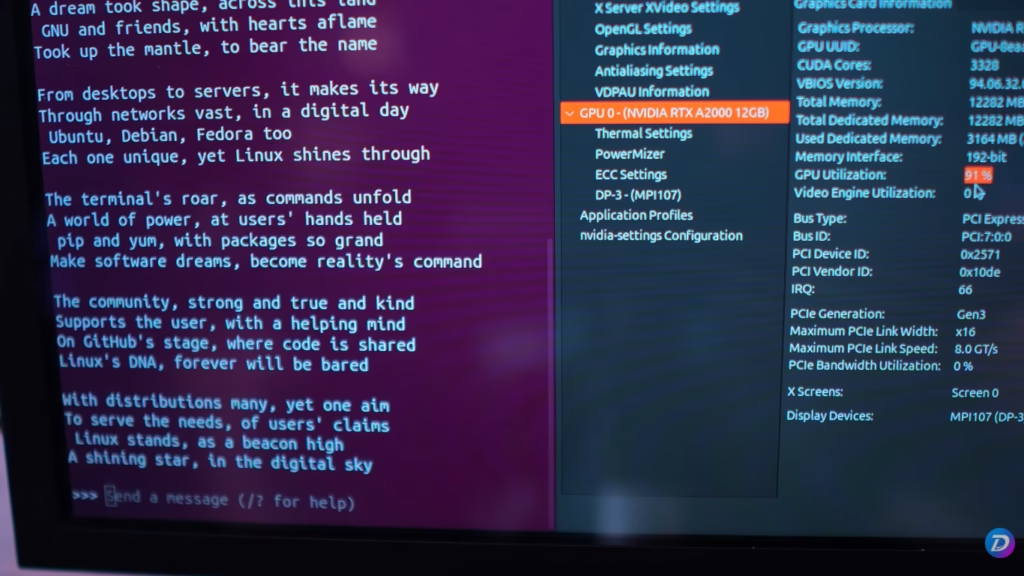

Ao observar o monitoramento do sistema, ficou claro o papel da GPU. A CPU permaneceu relativamente tranquila, enquanto a placa de vídeo assumiu o trabalho pesado, chegando a picos altos de utilização durante tarefas mais complexas.

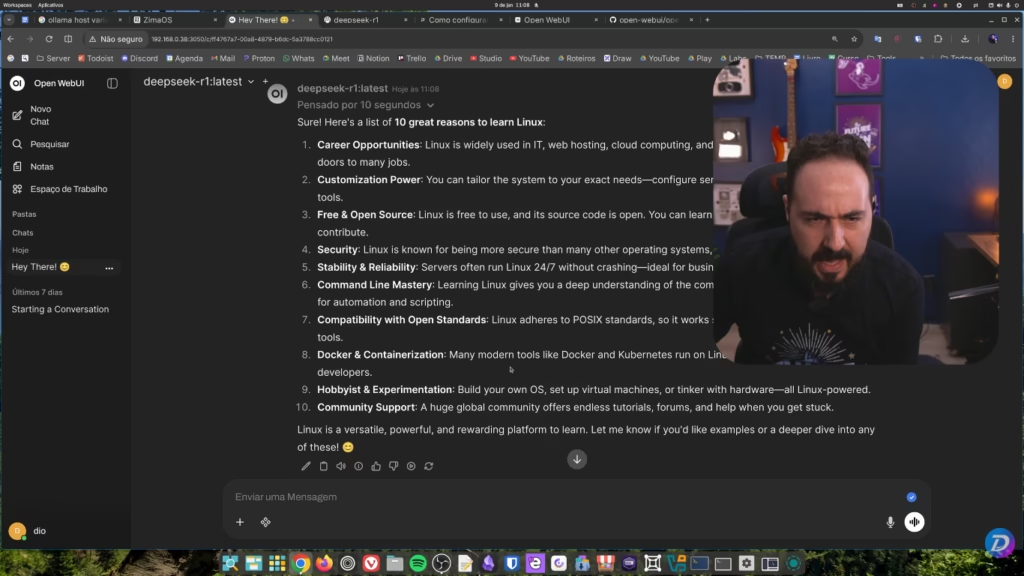

Conversar com um modelo de IA pelo terminal funciona, mas não é exatamente a experiência mais agradável. Para resolver isso, a solução foi integrar o Ollama a uma interface web: o Open WebUI.

Depois de alguns ajustes para permitir conexões externas, o servidor passou a aceitar requisições a partir de outros computadores da rede local. Com isso, foi possível acessar os modelos por meio de uma interface gráfica moderna, parecida com serviços de IA online.

A partir daí, ficou fácil testar outros modelos, comparar respostas e até rodar tarefas mais exigentes, sempre monitorando o uso de memória e GPU.

E o teste de Crysis?

Ah, sim. Faltava uma coisa.

O teste com Crysis é quase uma promessa simbólica. A GPU, apesar de poderosa para IA, não é voltada para jogos. O Steam instalado via Snap trouxe ainda mais complicações, e mesmo tentando diferentes versões do Proton, o jogo simplesmente não quis rodar.

Depois de algum tempo investigando, a decisão foi simples: não valia a pena insistir. O objetivo do projeto nunca foi rodar jogos, e sim explorar IA local.

Um experimento que deu certo

Apesar dos sustos, improvisos e pequenas frustrações, o projeto foi um sucesso. Com hardware relativamente antigo, reaproveitado e longe de ser topo de linha, foi possível montar um computador capaz de rodar modelos de IA localmente, de forma privada e eficiente.

Esse setup não é definitivo, mas abre inúmeras possibilidades: virtualização, GPU passthrough, testes mais avançados com modelos maiores e até novos projetos de infraestrutura doméstica.

Existem muitas formas de aproveitar o melhor da inteligência artificial sem abrir mão de controle e privacidade. E esse tipo de experimento mostra que, com curiosidade e um pouco de coragem, isso está muito mais ao alcance do que parece.

E enquanto decidimos o que faremos com este servidor, confira algumas dicas sobre como incorporar IA ao seu fluxo de trabalho, sem os exageros de quem quer te vender algo.